一、前言

二、什麼是Transformers

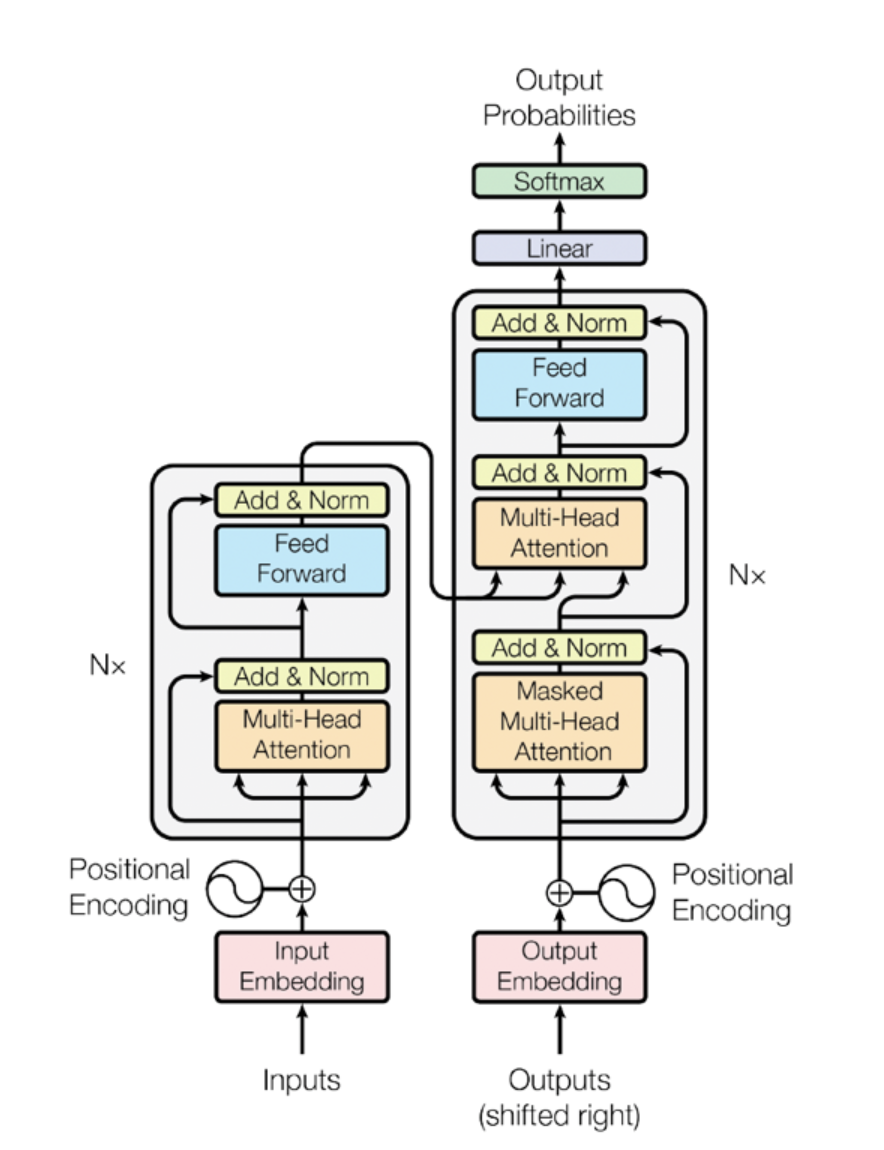

Transformer 是一種神經網路架構,可將輸入序列轉換或變更為輸出序列。

在自然語言處理中,它能夠通過注意力機制對序列中的所有位置進行建模,核心是「自注意力機制」(Self-Attention),它能夠讓模型在處理一個詞時,考慮到句子中所有其他詞的位置和關聯,從而更好地捕捉上下文。

三、架構

圖片取自:https://aws.amazon.com/tw/what-is/transformers-in-artificial-intelligence/

四、應用

文本生成:像GPT這些基於Transformers的模型能夠生成自然流暢的文本。比如,GPT-3 就是利用大量文本數據進行訓練,能夠生成逼真的文本回應。

語言翻譯:Transformers在語言翻譯方面的應用也非常成功,像Google翻譯現在就是基於Transformers模型的改進版本,能夠準確理解並翻譯不同語言之間的上下文。

圖像生成:除了在NLP領域,Transformers也逐漸應用於計算機視覺領域。比如,Vision Transformer (ViT)模型通過將圖像分成小塊來進行處理,能夠實現圖像分類、生成等任務。

五、分析

Transformers架構是生成式AI中非常關鍵的一項技術,它通過自注意力機制提高了模型在處理序列數據上的效率和準確性。使得它在處理長文本或語言翻譯等任務時具有很大的優勢。當前許多生成式AI模型都是基於 Transformers的架構,比如GPT和BERT,它們在文本生成、語言理解等領域取得了顯著的效果。